目标: 在运行 HarmonyOS Next 的华为 MateBook Pro 上侧载安装第三方应用程序。

注:本教程同样适用于在运行 HarmonyOS Next 的华为手机上侧载安装第三方应用程序。

所需准备

一台运行 HarmonyOS Next 的华为 MateBook Pro。

一台 Windows 电脑。

一根数据线:

USB-A to Type-C

或 Type-C to Type-C (确保能将两台电脑连接)。

网络连接:两台电脑需在同一局域网下(用于无线调试连接)。

步骤详解

第一步:鸿蒙 PC (MateBook Pro) 端设置 (启用开发者模式与调试)

连接设备: 使用数据线将鸿蒙 MateBook Pro 连接到 Windows 电脑。

打开设置: 在鸿蒙 PC 上,进入

设置。进入关于本机: 在设置中,找到并点击

关于本机或您的电脑型号。启用开发者模式:

在“关于本机”界面,找到

软件版本或HarmonyOS 版本。连续点击

软件版本/HarmonyOS 版本文字 5 次以上。系统会提示“您已处于开发者模式”或提示重启进入开发者模式。按提示重启电脑(如果需要)。

打开开发者选项:

重启后,回到

设置->系统->开发者选项(路径可能略有不同,在“系统和更新”或“隐私与安全”下查找)。启用 USB 调试:

在开发者选项中,找到

USB 调试,将其开启。首次开启时,可能会弹出提示(连接线后或稍后操作时),点击

允许。注意提示:系统可能提示“Matebook Pro 上的右上角的 Type-C 口可以进行调试”,确保使用正确的接口连接调试线。如果弹出“始终允许本机调试”选项,勾选并允许。

启用并记录无线调试信息:

在开发者选项中,找到

无线调试,将其开启。开启后,系统会显示一个 IP 地址和端口号(例如

192.168.x.x:xxxxx)。务必准确记下这个 IP 地址和端口号,后续在 Windows 端连接时必须用到。至此,鸿蒙 PC 端的准备工作完成。

第二步:Windows 电脑端操作 (使用小白调试助手)

获取工具和 HAP 包:

访问包含 HarmonyOS Next 可用 HAP 包的资源(如 GitHub 上的相关仓库,搜索 “HarmonyOS Next HAP”)。

下载小白调试助手:

在工具仓库中找到

小白调试助手或类似名称。点击

Latest(最新版本)。点击

Download下载其 Windows 版压缩包(.zip文件)。下载目标应用的 HAP 包(以 ClashBox 为例,你也可以使用自己已有的 .hap 文件):

在应用仓库中找到

ClashBox。同样点击

Latest->Download下载其 HAP 包(.hap文件)。准备小白调试助手:

将下载的小白调试助手压缩包解压到一个非中文且无空格路径的文件夹。

进入解压后的文件夹,找到可执行文件。双击运行。根据 Windows SmartScreen 或安全软件提示(若有),选择

更多信息->仍要运行。登录华为开发者账号 (强烈推荐):

在小白调试助手界面,找到登录入口(通常在界面顶部或设置中),点击

登录。使用您的华为开发者账号登录(登录时,您的华为手机可能会收到验证码,或在鸿蒙PC上验证)。

输入验证码,并在授权请求页面点击

允许。登录成功后,界面通常会显示您的账号昵称或ID。重要: 开发者账号签发的应用证书有效期通常为 6 个月,普通账号仅 14 天。为方便使用,建议申请华为开发者账号。

连接鸿蒙设备:

在小白调试助手主界面,找到

连接设备、添加设备或类似功能的按钮并点击。在弹出的连接窗口(通常是输入IP和端口的对话框)中:

输入您在鸿蒙 PC 上

无线调试功能中记录的 IP 地址。输入记录的 端口号。

点击

确定、连接或OK。连接成功:如果地址和端口输入正确,且鸿蒙 PC 的开发者选项已开启无线调试:

鸿蒙 PC 可能弹出调试请求(“允许调试?”),勾选“始终允许”并点击

允许。小白调试助手界面会显示“连接成功”或目标设备信息。

(若未弹出提示框但连接成功,也属正常)

第三步:安装第三方 HAP 包

选择 HAP 包:

确保设备已连接成功。

在小白调试助手界面,找到

选择 HAP、加载 HAP、安装应用或类似按钮(通常在文件菜单或主功能区)。点击该按钮,浏览文件系统,找到您下载好的目标 HAP 文件(如

ClashBox-xxx.hap),选中并点击打开。开始安装:

选择好 HAP 文件后,小白调试助手界面通常会激活

开始调试、安装或运行按钮。点击

开始调试或安装。等待安装完成:

小白调试助手会开始处理 HAP 包:进行签名、推送到设备并安装。

观察进度条或日志输出,耐心等待直至提示“安装成功”。

第四步:在鸿蒙 PC 上使用安装的应用

安装完成后,返回您的鸿蒙 MateBook Pro。

在桌面或

开始菜单中,查找您刚刚安装的应用图标(如ClashBox)。点击图标即可启动使用该应用。

常见问题处理

签名错误/证书问题:在小白调试助手内寻找 **

清理缓存、重置证书、重新登录** 或类似选项。执行后,重新登录开发者账号,再尝试安装。确保登录的是开发者账号。Java 环境报错:如果小白调试助手提示需要 Java 环境(如

java命令未找到),按照其提示点击安装,它会引导下载并安装所需的 Java Runtime Environment (JRE)。连接失败:

检查鸿蒙 PC 的

无线调试IP 和端口号是否变化(息屏、重启、网络切换可能导致变化),在开发者选项里重新确认并输入。确保两台电脑在同一局域网。

检查鸿蒙 PC 的 **

USB 调试和无线调试是否已开启**。尝试在鸿蒙 PC 的开发者选项中关闭再重新开启

无线调试,获取新的端口号。其他报错:查阅小白调试助手官方的使用说明或 GitHub 仓库的 Issue 区寻求解决方案。

原标题:关于 PHP 获取 IP 地址的几种方法

PHP 获取客户端的 IP 地址有 4 种方式:

REMOTE_ADDR:浏览当前页面的用户计算机的 IP 地址

HTTP_X_FORWARDED_FOR:记录代理信息,会把每一层代理都记录

HTTP_CLIENT_IP:客户端的 IP

X-Real-IP:没有标准,由上一跳决定

REMOTE_ADDR 一般是不能伪造的,因为是通过服务器与客户端握手协议来获取的。而 HTTP_X_FORWARDED_FOR 和 HTTP_CLIENT_IP 是在 header 信息里面,所以客户端是可以进行很轻松的伪造。下面是对这三种方式详解:

https://www.test404.com/post-1448.html

https://www.cnblogs.com/mypath/articles/5239687.html

一、关于 REMOTE_ADDR

这个变量获取到的是“直接来源”的 IP 地址,所谓“直接来源”指的是直接请求该地址的客户端 IP 。这个 IP 在单服务器的情况下,很准确的是客户端 IP ,无法伪造。当然并不是所有的程序都一定是单服务器,比如在采用负载均衡的情况(比如采用 haproxy 或者 nginx 进行负载均衡),这个 IP 就是转发机器的 IP ,因为过程是客户端 -> 负载均衡 -> 服务端。是由负载均衡直接访问的服务端而不是客户端。

二、关于 HTTP_X_FORWARDED_FOR 和 HTTP_CLIENT_IP

基于“一”,在负载均衡的情况下直接使用 REMOTE_ADDR 是无法获取客户端 IP 的,这就是一个问题,必须解决。于是就衍生出了负载均衡端将客户端 IP 加入到 HEAD 中发送给服务端,让服务端可以获取到客户端的真实 IP 。当然也就产生了各位所说的伪造,毕竟 HEAD 除了协议里固定的那几个数据,其他数据都是可自定义的。

三、为何网上找到获取客户端 IP 的代码都要依次获取 HTTP_CLIENT_IP 、 HTTP_X_FORWARDED_FOR 和 REMOTE_ADDR

基于“一”和“二”以及对程序通用性的考虑,所以才这样做。 假设你在程序里直接写死了 REMOTE_ADDR ,有一天你们的程序需要做负载均衡了,那么你有得改了。当然如果你想这么做也行,看个人爱好和应用场景。也可以封装一个只有 REMOTE_ADDR 的方法,等到需要的时候改这一个方法就行了。

X_FORWARDED_FOR 与 X-Real-IP 的区别:

X_FORWARDED_FOR:记录了所有链路里的代理 IP 值,比如下面所说的,经过了 3 次代理,分别是 1.1.1.1, 2.2.2.2, 3.3.3.3,其中 1.1.1.1 是客户端 IP,2.2.2.2 是代理服务器,接下来同理。

X-Real-IP:是只会记录前一次代理的 IP 地址。

一般来说,X-Forwarded-For是用于记录代理信息的,每经过一级代理(匿名代理除外),代理服务器都会把这次请求的来源IP追加在X-Forwarded-For中

来自4.4.4.4的一个请求,header 包含这样一行

代表请求由1.1.1.1发出,经过三层代理,第一层是2.2.2.2,第二层是3.3.3.3,而本次请求的来源IP4.4.4.4是第三层代理

而X-Real-IP,没有相关标准,上面的例子,如果配置了X-Read-IP,可能会有两种情况

所以 ,如果只有一层代理,这两个头的值就是一样的。

那一般在后端取值(比如 node.js 通过 nginx 代理)是用哪个值呢?我看 sf 上看一般推荐是用 X-Forwarded-For,直接用 X-Real-IP 岂不是更方便点?

X-Forwarded-For 确实是一般的做法

他在正向(如 squid)反向(如 nginx)代理中都是标准用法,而正向代理中是没有 x-real-ip 相关的标准的,也就是说,如果用户访问你的 nginx 反向代理之前,还经过了一层正向代理,你即使在 nginx 中配置了 x-real-ip,取到的也只是正向代理的 IP 而不是客户端真实 IP

大部分 nginx 反向代理配置文章中都没有推荐加上 x-real-ip ,而只有 x-forwarded-for,因此更通用的做法自然是取 x-forwarded-for

多级代理很少见,只有一级代理的情况下二者是等效的

如果有多级代理,x-forwarded-for 效果是大于 x-real-ip 的,可以记录完整的代理链路

1、将以下代码保存为 Client.php

// php 脚本开始

$ch = curl_init();

$url = "http://localhost/ser.php";

$header = array('CLIENT-IP:208.165.188.175', 'X-FORWARDED-FOR:208.165.188.175');

// 声明伪造 head 请求头

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_HTTPHEADER, $header);

curl_setopt($ch, CURLOPT_RETURNTRANSFER,true);

$page_content = curl_exec($ch); curl_close($ch);

echo $page_content;

2、将以下代码保存为 ser.php

// php 脚本开始

echo getenv('HTTP_CLIENT_IP');

echo getenv('HTTP_X_FORWARDED_FOR');

echo getenv('REMOTE_ADDR');

测试结果为

208.165.188.175

208.165.188.175

127.0.0.1上面结果可看出,http_client_ip、http_x_forwarded_for 都被伪造了,而 remote_addr 还是127.0.0.1 就是客户端 IP

总结:

如果我们没用到负载均衡(CDN)的话直接用 REMOTE_ADDR 获取 IP。

如果使用了一级 CDN 的话,CDN 会把 REMOTE_ADDR 转发成 X-Real-IP,我们服务器可以获取 X-Real-IP 来获取 IP 值。如果是多级 CDN 的话需要我们来做 nginx 代理,详细:https://www.cnblogs.com/princessd8251/articles/6268943.html

就是第一台负载服务器获取 REMOTE_ADDR 转发成 X-Real-IP,之后的去继承前一台的 X-Real-IP 就可以了,这里记住必须是去继承,不然第二台会把第一台的 REMOTE_ADDR 转发成 X-Real-IP 导致错误。

在 discuz! 中的获取 IP 的方法:

private function _get_client_ip() {

$ip = $_SERVER['REMOTE_ADDR'];

if (isset($_SERVER['HTTP_CLIENT_IP']) && preg_match('/^([0-9]{1,3}\.){3}[0-9]{1,3}$/', $_SERVER['HTTP_CLIENT_IP'])) {

$ip = $_SERVER['HTTP_CLIENT_IP'];

} elseif(isset($_SERVER['HTTP_X_FORWARDED_FOR']) AND preg_match_all('#\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}#s', $_SERVER['HTTP_X_FORWARDED_FOR'], $matches)) {

foreach ($matches[0] AS $xip) {

if (!preg_match('#^(10|172\.16|192\.168)\.#', $xip)) {

$ip = $xip;

break;

}

}

}

return $ip;

}这里 DZ 为了符合有些用户会用代理,所以才首先使用了两个容易伪造的方法,如果有需要可以自行修改。

编者按:今天腾讯万技师同学的这篇技术总结必须强烈安利下,目录清晰,层次分明,每个接口都有对应的简介、系统要求、实例、核心代码以及超实用的思维发散,帮你直观把这些知识点get起来。以现在HTML 5的势头,同志们,你看到的这些,可都是钱呐。

十二年前,无论多么复杂的布局,在我们神奇的table面前,都不是问题;

十年前,阿捷的一本《网站重构》,为我们开启了新的篇章;

八年前,我们研究yahoo.com,惊叹它在IE5下都表现得如此完美;

六年前,Web标准化成了我们的基础技能,我们开始研究网站性能优化;

四年前,我们开始研究自动化工具,自动化测试,谁没玩过nodejs都不好意思说是页面仔;

二年前,各种终端风起云涌,响应式、APP开发都成为了我们研究的范围,CSS3动画开始风靡;

如今,CSS3动画、Canvas、SVG、甚至webGL你已经非常熟悉,你是否开始探寻,接下来,我们可以玩什么,来为我们项目带来一丝新意?

没错,本文就是以HTML5 Device API为核心,对HTML5的一些新接口作了一个完整的测试,希望能让大家有所启发。

目录:

一、让音乐随心而动 – 音频处理 Web audio API

二、捕捉用户摄像头 – 媒体流 Media Capture

三、你是逗逼? – 语音识别 Web Speech API

四、让我尽情呵护你 – 设备电量 Battery API

五、获取用户位置 – 地理位置 Geolocation API

六、把用户捧在手心 – 环境光 Ambient Light API

七、陀螺仪 Deviceorientation

八、Websocket

九、NFC

十、震动 - Vibration API

十一、网络环境 Connection API

一、让音乐随心而动 – 音频处理 Web audio API

简介:

Audio对象提供的只是音频文件的播放,而Web Audio则是给了开发者对音频数据进行分析、处理的能力,比如混音、过滤。

系统要求:

ios6+、android chrome、android firefox

实例:

http://sy.qq.com/brucewan/device-api/web-audio.html

核心代码:

var context = new webkitAudioContext();

var source = context.createBufferSource(); // 创建一个声音源

source.buffer = buffer; // 告诉该源播放何物

createBufferSourcesource.connect(context.destination); // 将该源与硬件相连

source.start(0); //播放

技术分析:

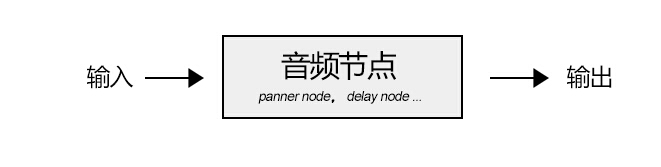

当我们加载完音频数据后,我们将创建一个全局的AudioContext对象来对音频进行处理,AudioContext可以创建各种不同功能类型的音频节点AudioNode,比如

1、源节点(source node)

我们可以使用两种方式加载音频数据:

<1>、audio标签

var sound, audio = new Audio();

audio.addEventListener('canplay', function() {

sound = context.createMediaElementSource(audio);

sound.connect(context.destination);

});

audio.src = '/audio.mp3';

<2>、XMLHttpRequest

var sound, context = createAudioContext();

var audioURl = '/audio.mp3'; // 音频文件URL

var xhr = new XMLHttpRequest();

xhr.open('GET', audioURL, true);

xhr.responseType = 'arraybuffer';

xhr.onload = function() {

context.decodeAudioData(request.response, function (buffer) {

source = context.createBufferSource();

source.buffer = buffer;

source.connect(context.destination);

}

}

xhr.send();

2、分析节点(analyser node)

我们可以使用AnalyserNode来对音谱进行分析,例如:

var audioCtx = new (window.AudioContext || window.webkitAudioContext)();

var analyser = audioCtx.createAnalyser();

analyser.fftSize = 2048;

var bufferLength = analyser.frequencyBinCount;

var dataArray = new Uint8Array(bufferLength);

analyser.getByteTimeDomainData(dataArray);

function draw() {

drawVisual = requestAnimationFrame(draw);

analyser.getByteTimeDomainData(dataArray);

// 将dataArray数据以canvas方式渲染出来

};

draw();

3、处理节点(gain node、panner node、wave shaper node、delay node、convolver node等)

不同的处理节点有不同的作用,比如使用BiquadFilterNode调整音色(大量滤波器)、使用ChannelSplitterNode分割左右声道、使用GainNode调整增益值实现音乐淡入淡出等等。

需要了解更多的音频节点可能参考:

https://developer.mozilla.org/en-US/docs/Web/API/Web_Audio_API

4、目的节点(destination node)

所有被渲染音频流到达的最终地点

思维发散:

1、可以让CSS3动画跟随背景音乐舞动,可以为我们的网页增色不少;

2、可以尝试制作H5酷酷的变声应用,增加与用户的互动;

3、甚至可以尝试H5音乐创作。

看看google的创意:http://v.youku.com/v_show/id_XNTk0MjQyNDMy.html

二、捕捉用户摄像头 – 媒体流 Media Capture

简介:

通过getUserMedia捕捉用户摄像头获取视频流和通过麦克风获取用户声音。

系统要求:

android chrome、android firefox

实例:

捕获用户摄像头 捕获用户麦克风

http://sy.qq.com/brucewan/device-api/camera.html

http://sy.qq.com/brucewan/device-api/microphone-usermedia.html

核心代码:

1、摄像头捕捉

navigator.webkitGetUserMedia ({video: true}, function(stream) {

video.src = window.URL.createObjectURL(stream);

localMediaStream = stream;

}, function(e){

})

2、从视频流中拍照

btnCapture.addEventListener('touchend', function(){

if (localMediaStream) {

canvas.setAttribute('width', video.videoWidth);

canvas.setAttribute('height', video.videoHeight);

ctx.drawImage(video, 0, 0);

}

}, false);

3、用户声音录制

navigator.getUserMedia({audio:true}, function(e) {

context = new audioContext();

audioInput = context.createMediaStreamSource(e);

volume = context.createGain();

recorder = context.createScriptProcessor(2048, 2, 2);

recorder.onaudioprocess = function(e){

recordingLength += 2048;

recorder.connect (context.destination);

}

}, function(error){});

4、保存用户录制的声音

var buffer = new ArrayBuffer(44 + interleaved.length * 2);

var view = new DataView(buffer);

fileReader.readAsDataURL(blob); // android chrome audio不支持blob

… audio.src = event.target.result;

思维发散:

1、从视频拍照自定义头像;

2、H5视频聊天;

3、结合canvas完成好玩的照片合成及处理;

4、结合Web Audio制作有意思变声应用。

三、你是逗逼? – 语音识别 Web Speech API简介:

1、将文本转换成语音;

2、将语音识别为文本。

系统要求:

ios7+,android chrome,android firefox

测试实例:

http://sy.qq.com/brucewan/device-api/microphone-webspeech.html

核心代码:

1、文本转换成语音,使用SpeechSynthesisUtterance对象;

var msg = new SpeechSynthesisUtterance();

var voices = window.speechSynthesis.getVoices();

msg.volume = 1; // 0 to 1

msg.text = ‘识别的文本内容’;

msg.lang = 'en-US';

speechSynthesis.speak(msg);

2、语音转换为文本,使用SpeechRecognition对象。

var newRecognition = new webkitSpeechRecognition();

newRecognition.onresult = function(event){

var interim_transcript = '';

for (var i = event.resultIndex; i < event.results.length; ++i) {

final_transcript += event.results[i][0].transcript;

}

};

测试结论:

1、Android支持不稳定;语音识别测试失败(暂且认为是某些内置接口被墙所致)。

思维发散:

1、当语音识别成为可能,那声音控制将可以展示其强大的功能。在某些场景,比如开车、网络电视,声音控制将大大改善用户体验;

2、H5游戏中最终分数播报,股票信息实时声音提示,Web Speech都可以大放异彩。

四、让我尽情呵护你 – 设备电量 Battery API简介:

查询用户设备电量及是否正在充电。

系统要求:

android firefox

测试实例:

http://sy.qq.com/brucewan/device-api/battery.html

核心代码:

var battery = navigator.battery || navigator.webkitBattery || navigator.mozBattery || navigator.msBattery;

var str = '';

if (battery) {

str += '<p>你的浏览器支持HTML5 Battery API</p>';

if(battery.charging) {

str += '<p>你的设备正在充电</p>';

} else {

str += '<p>你的设备未处于充电状态</p>';

}

str += '<p>你的设备剩余'+ parseInt(battery.level*100)+'%的电量</p>';

} else {

str += '<p>你的浏览器不支持HTML5 Battery API</p>';

}

测试结论:

1、QQ浏览器与UC浏览器支持该接口,但未正确显示设备电池信息;

2、caniuse显示android chrome42支持该接口,实测不支持。

思维发散:

相对而言,我觉得这个接口有些鸡肋。

很显然,并不合适用HTML5做电池管理方面的工作,它所提供的权限也很有限。

我们只能尝试做一些优化用户体验的工作,当用户设备电量不足时,进入省电模式,比如停用滤镜、摄像头开启、webGL、减少网络请求等。

五、获取用户位置 – 地理位置 Geolocation简介:

Geolocation API用于将用户当前地理位置信息共享给信任的站点,目前主流移动设备都能够支持。

系统要求:

ios6+、android2.3+

测试实例:

http://sy.qq.com/brucewan/device-api/geolocation.html

核心代码:

var domInfo = $("#info");

// 获取位置坐标

if (navigator.geolocation) {

navigator.geolocation.getCurrentPosition(showPosition,showError);

}

else{

domInfo.innerHTML="抱歉,你的浏览器不支持地理定位!";

}

// 使用腾讯地图显示位置

function showPosition(position) {

var lat=position.coords.latitude;

var lon=position.coords.longitude;

mapholder = $('#mapholder')

mapholder.style.height='250px';

mapholder.style.width = document.documentElement.clientWidth + 'px';

var center = new soso.maps.LatLng(lat, lon);

var map = new soso.maps.Map(mapholder,{

center: center,

zoomLevel: 13

});

var geolocation = new soso.maps.Geolocation();

var marker = null;

geolocation.position({}, function(results, status) {

console.log(results);

var city = $("#info");

if (status == soso.maps.GeolocationStatus.OK) {

map.setCenter(results.latLng);

domInfo.innerHTML = '你当前所在城市: ' + results.name;

if (marker != null) {

marker.setMap(null);

}

// 设置标记

marker = new soso.maps.Marker({

map: map,

position:results.latLng

});

} else {

alert("检索没有结果,原因: " + status);

}

});

}

测试结论:

1、Geolocation API的位置信息来源包括GPS、IP地址、RFID、WIFI和蓝牙的MAC地址、以及GSM/CDMS的ID等等。规范中没有规定使用这些设备的先后顺序。

2、初测3g环境下比wifi环境理定位更准确;

3、测试三星 GT-S6358(android2.3) geolocation存在,但显示位置信息不可用POSITION_UNAVAILABLE。

六、把用户捧在手心 – 环境光 Ambient Light简介:

Ambient Light API定义了一些事件,这些时间可以提供源于周围光亮程度的信息,这通常是由设备的光感应器来测量的。设备的光感应器会提取出辉度信息。

系统要求:

android firefox

测试实例:

http://sy.qq.com/brucewan/device-api/ambient-light.html

核心代码:

这段代码实现感应用前当前环境光强度,调整网页背景和文字颜色。

var domInfo = $('#info');

if (!('ondevicelight' in window)) {

domInfo.innerHTML = '你的设备不支持环境光Ambient Light API';

} else {

var lightValue = document.getElementById('dl-value');

window.addEventListener('devicelight', function(event) {

domInfo.innerHTML = '当前环境光线强度为:' + Math.round(event.value) + 'lux';

var backgroundColor = 'rgba(0,0,0,'+(1-event.value/100) +')';

document.body.style.backgroundColor = backgroundColor;

if(event.value < 50) {

document.body.style.color = '#fff'

} else {

document.body.style.color = '#000'

}

});

}

思维发散:

该接口适合的范围很窄,却能做出很贴心的用户体验。

1、当我们根据Ambient Light强度、陀螺仪信息、当地时间判断出用户正躺在床上准备入睡前在体验我们的产品,我们自然可以调整我们背景与文字颜色让用户感觉到舒适,我们还可以来一段安静的音乐,甚至使用Web Speech API播报当前时间,并说一声“晚安”,何其温馨;

2、该接口也可以应用于H5游戏场景,比如日落时分,我们可以在游戏中使用安静祥和的游戏场景;

3、当用户在工作时间将手机放在暗处,偷偷地瞄一眼股市行情的时候,我们可以用语音大声播报,“亲爱的,不用担心,你的股票中国中车马上就要跌停了”,多美的画面。

参考文献:

https://developer.mozilla.org/en-US/docs/Web/API

http://webaudiodemos.appspot.com/

http://www.w3.org/2009/dap/